Cảm xúc trong tiếng nói và phân tích thống kê ngữ liệu cảm xúc tiếng Việt

Tiếng nói ngày càng được sử dụng rộng rãi trong giao tiếp giữa người và máy. Việc trao đổi thông tin tiếng nói cũng chuyển từ việc phải sử dụng các cấu trúc chặt chẽ sang dùng các cách thức giao tiếp linh hoạt hơn, điều này giúp cho ứng dụng tiếng nói được phổ biến đến người dùng phổ thông một cách dễ dàng hơn.

Trang 1

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Trang 9

Trang 10

Tải về để xem bản đầy đủ

Bạn đang xem 10 trang mẫu của tài liệu "Cảm xúc trong tiếng nói và phân tích thống kê ngữ liệu cảm xúc tiếng Việt", để tải tài liệu gốc về máy hãy click vào nút Download ở trên

Tóm tắt nội dung tài liệu: Cảm xúc trong tiếng nói và phân tích thống kê ngữ liệu cảm xúc tiếng Việt

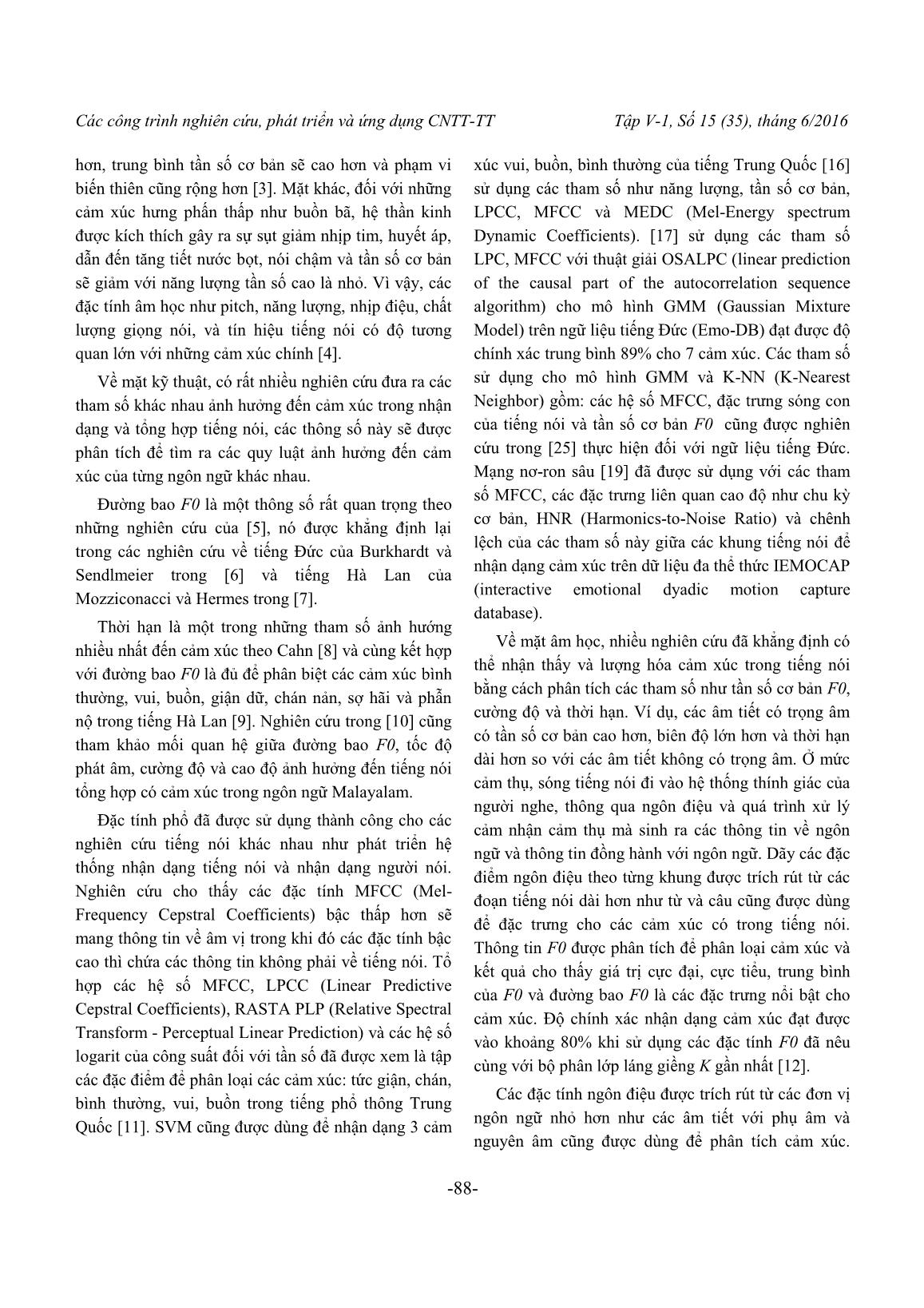

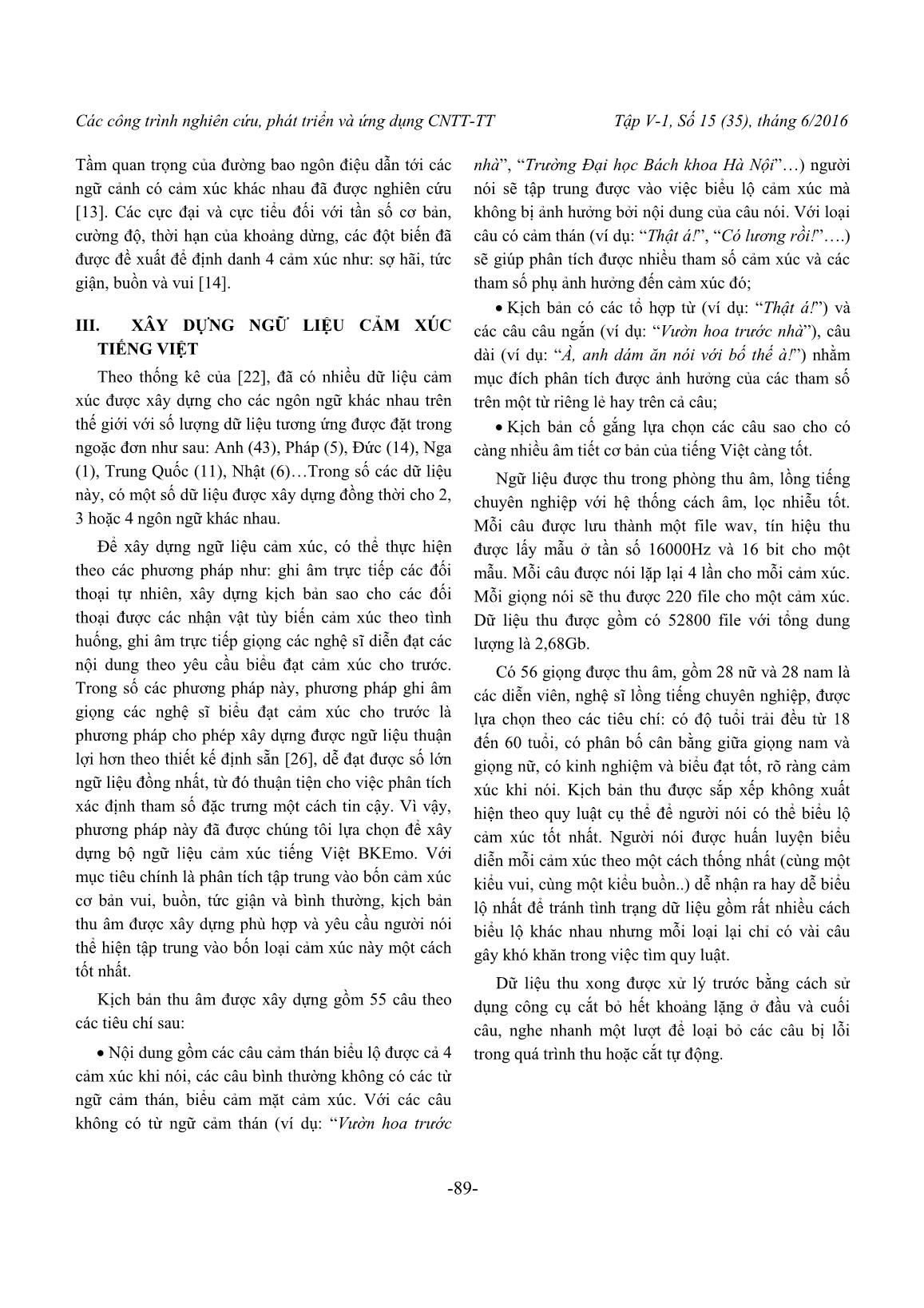

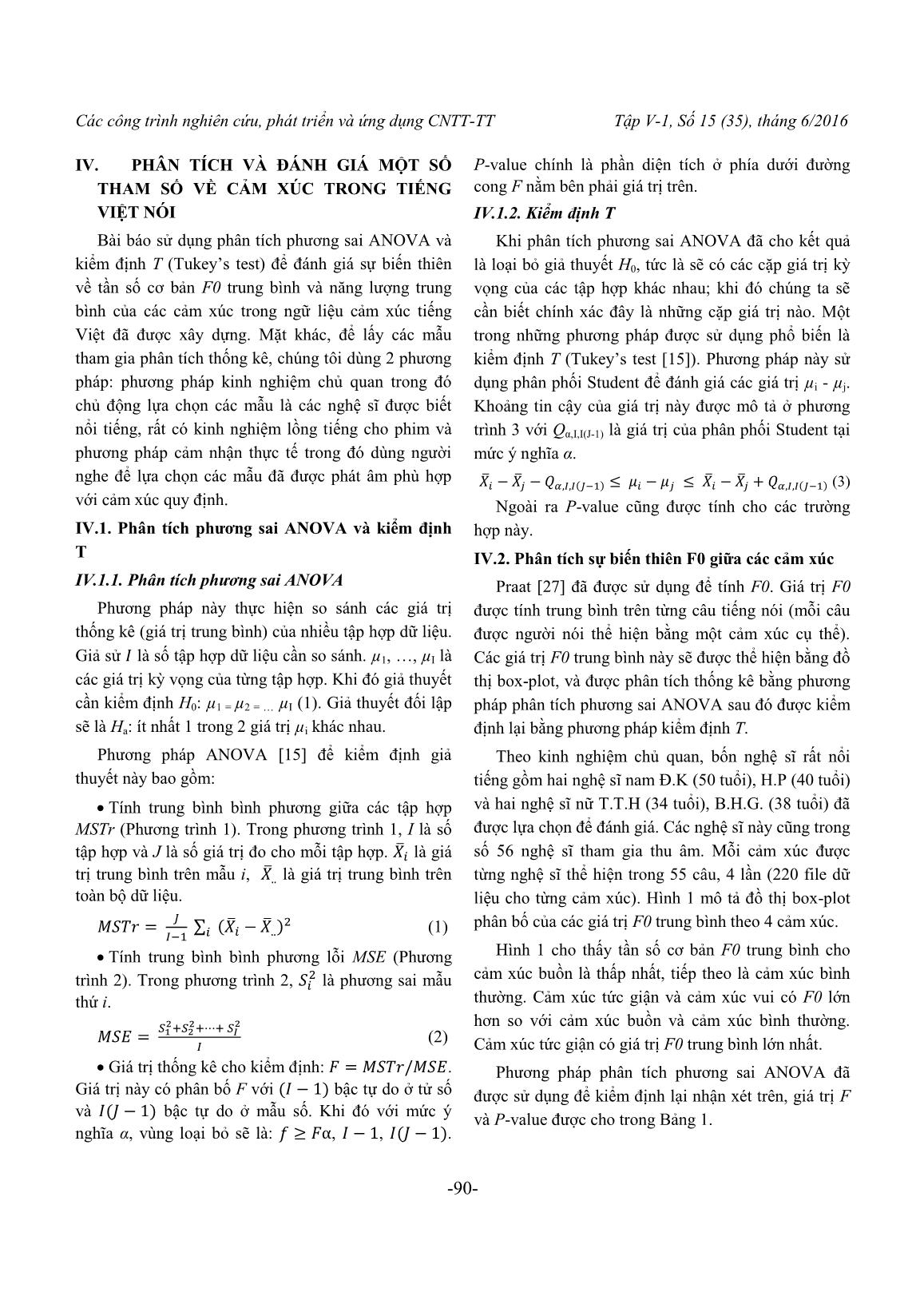

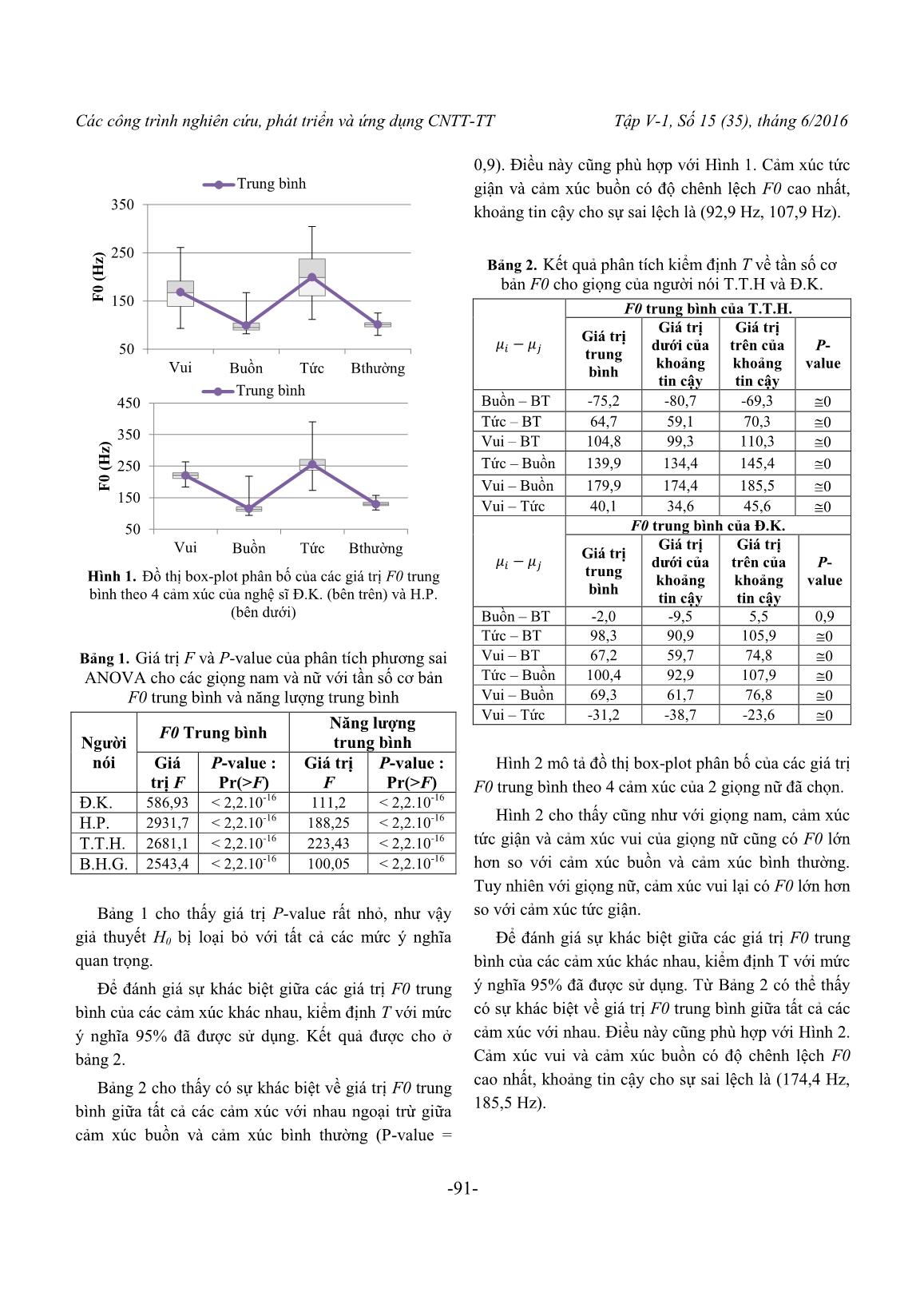

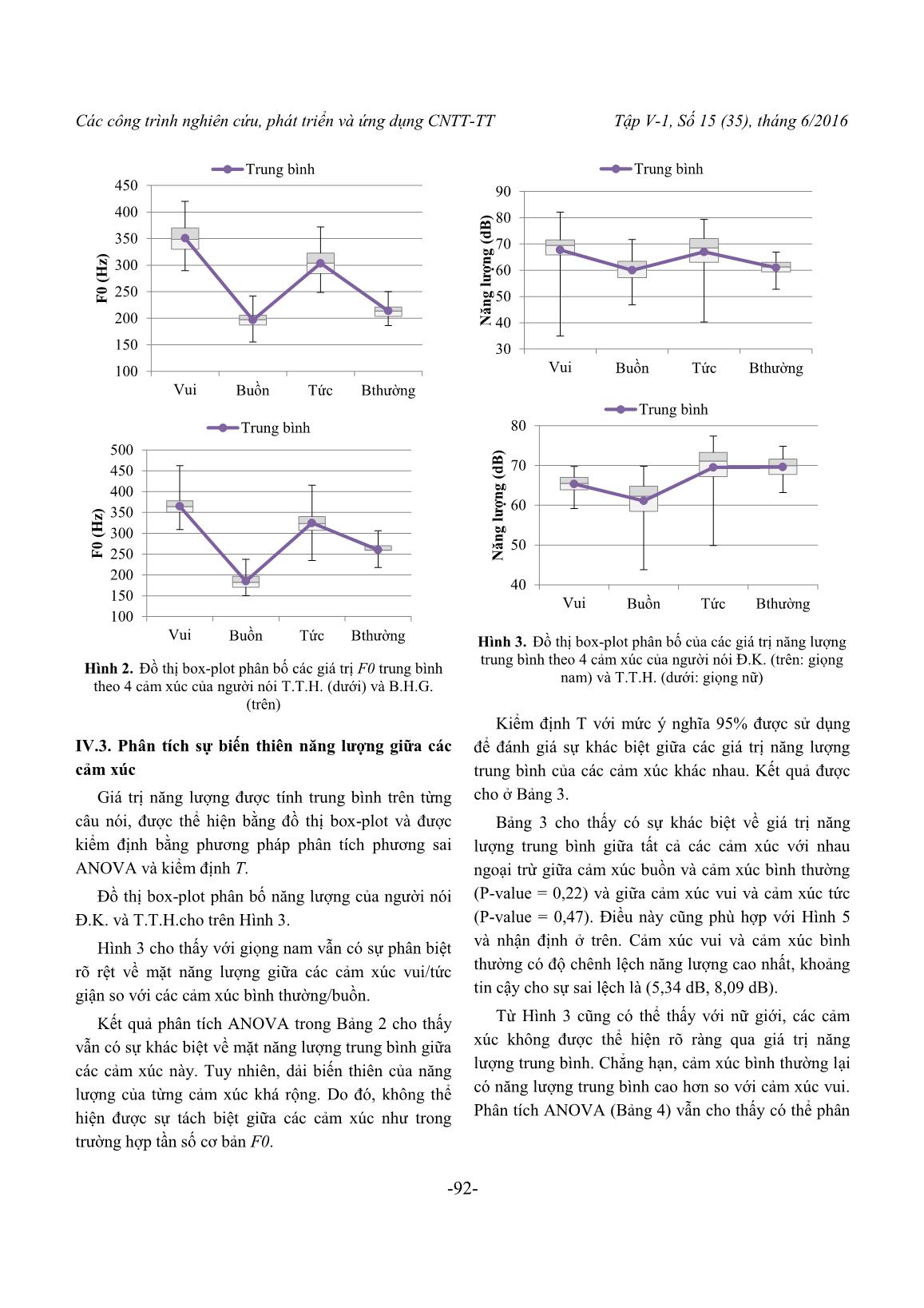

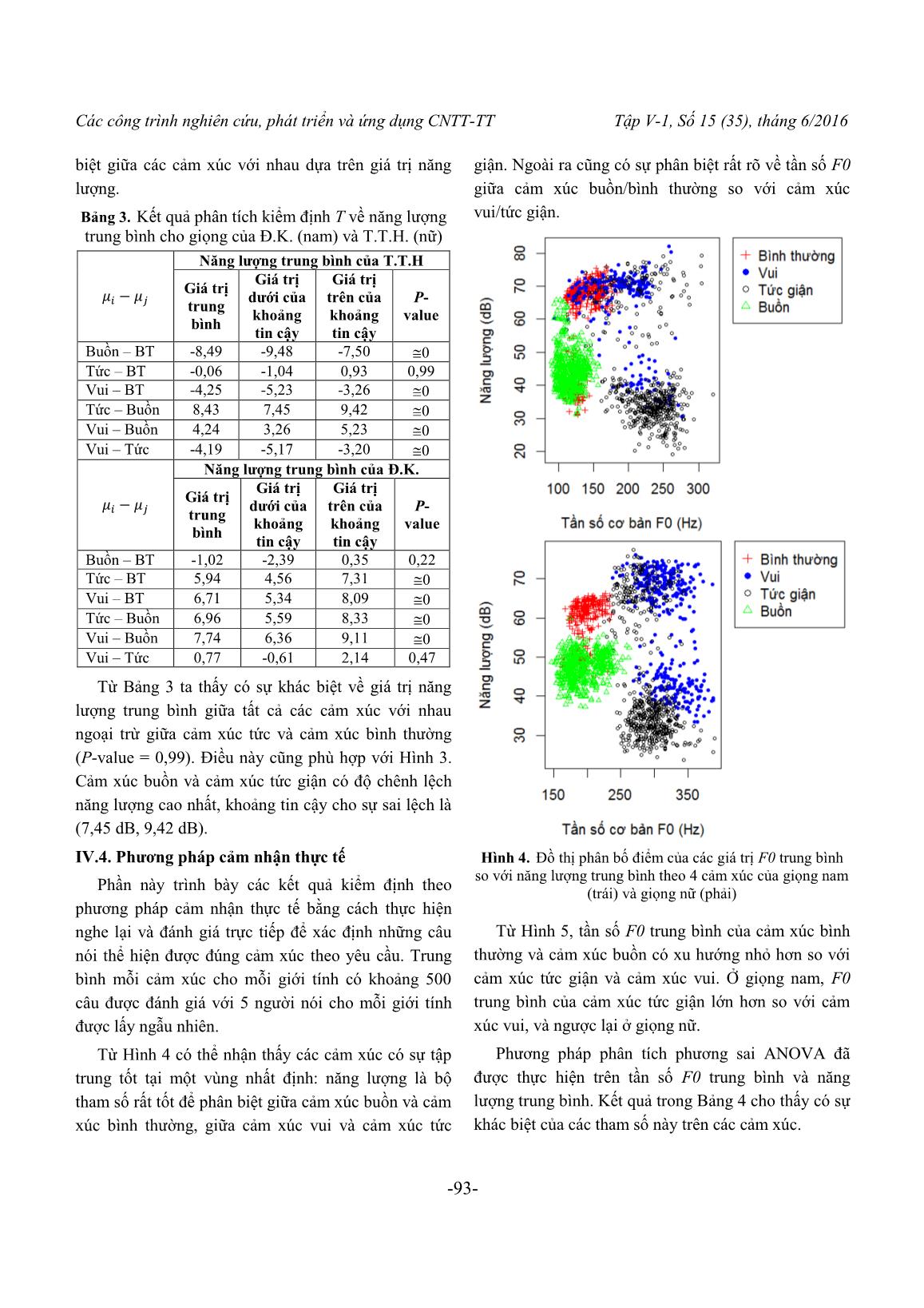

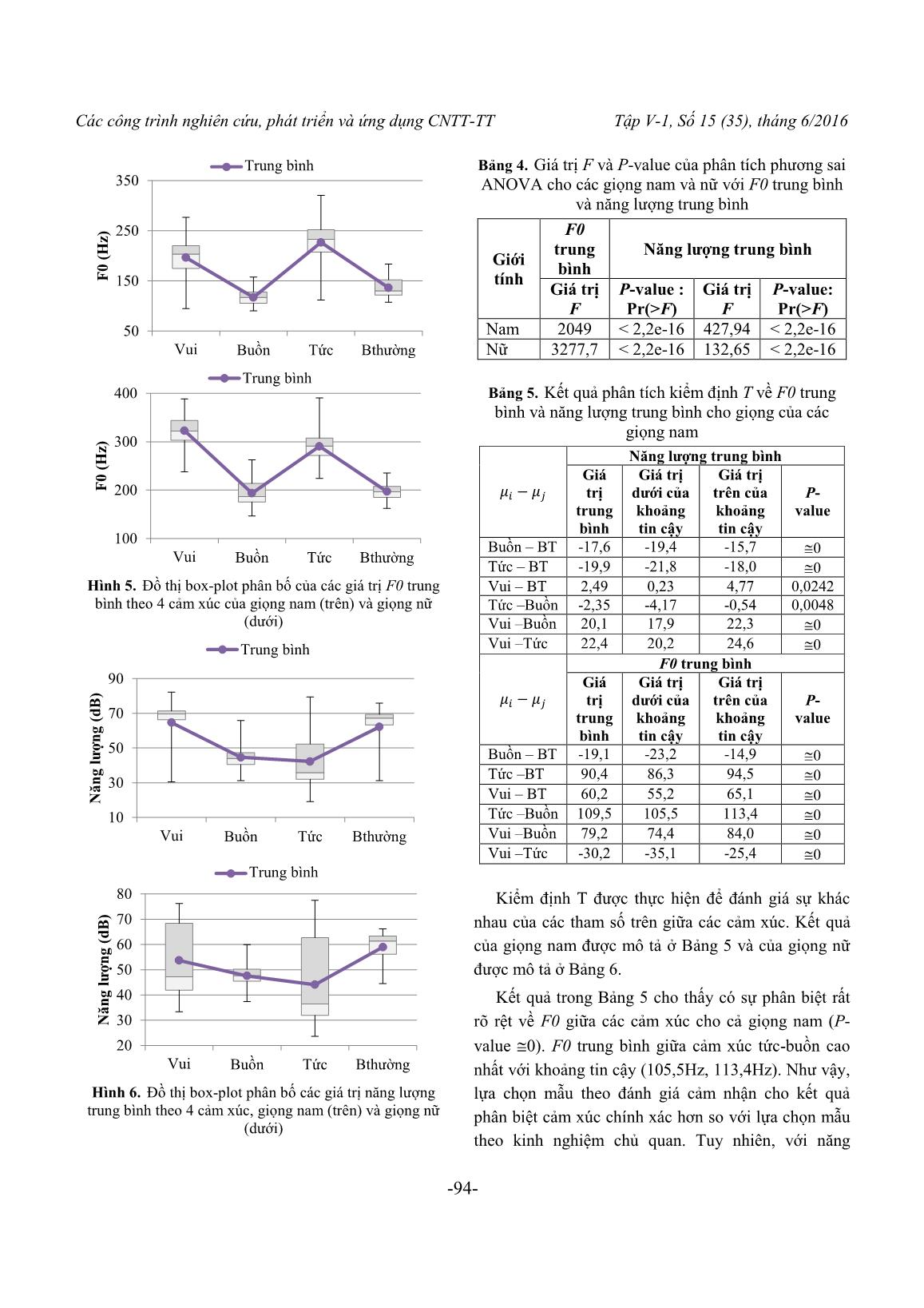

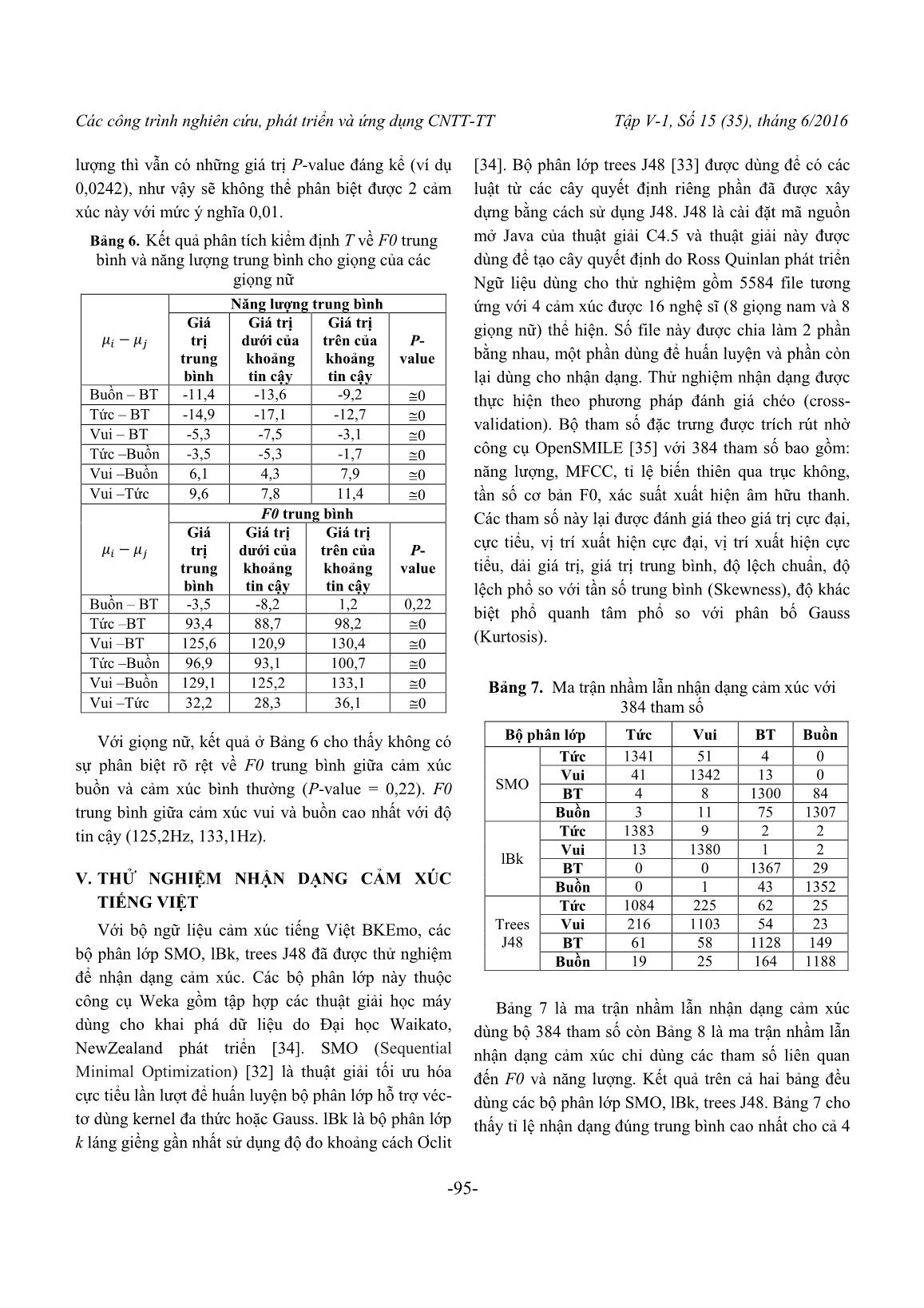

Các công trình nghiên cứu, phát triển và ứng dụng CNTT-TT Tập V-1, Số 15 (35), tháng 6/2016 -86- Cảm xúc trong tiếng nói và phân tích thống kê ngữ liệu cảm xúc tiếng Việt Speech Emotions and Statistical Analysis for Vietnamese Emotion Corpus Lê Xuân Thành, Đào Thị Lệ Thủy, Trịnh Văn Loan, Nguyễn Hồng Quang Abstract: Research on emotional speech has been carried out for many languages over the world and for Vietnamese, there was a beginning. This paper describes some research results on main features of four basic emotions: happiness, sadness, anger and neutrality. Our preliminary research on emotions of Vietnamese shows that in general anger and happiness correspond to speech energy and fundamental frequency higher than the one of neutral emotion, the sad emotion has the lowest values for energy and fundamental frequency. These comments come from the statistical methods such as analysis of variance (ANOVA) and Tukey’s test applied for our Vietnamese emotion corpus. The classifiers SMO, lBk, trees J48 have been used for preliminary identification of emotions based on BKEmo corpus. The highest recognition rate is 98.17% for the classifier lBk using 384 feature parameters and this rate decreases to 82.59% for the case using only 48 parameters relating to the F0 and intensity. Keywords: Speech, emotions, Vietnamese, corpus, ANOVA, Tukey’s test, fundamental frequency, speech energy, recognition, SMO, lBk, trees J48. I. GIỚI THIỆU Tiếng nói ngày càng được sử dụng rộng rãi trong giao tiếp giữa người và máy. Việc trao đổi thông tin tiếng nói cũng chuyển từ việc phải sử dụng các cấu trúc chặt chẽ sang dùng các cách thức giao tiếp linh hoạt hơn, điều này giúp cho ứng dụng tiếng nói được phổ biến đến người dùng phổ thông một cách dễ dàng hơn. Sự linh hoạt này không chỉ thể hiện ở việc sử dụng các cấu trúc câu lệnh linh hoạt mà còn hướng tới thể hiện ở các cung bậc cảm xúc khác nhau trong giao tiếp người máy. Để làm được điều này, các hệ thống tương tác người máy cần được trang bị thêm các tính năng mới. Các tính năng này bao gồm việc phân tích nội dụng của dữ liệu tiếng nói nhận được để lấy ra các thông tin như: cảm xúc trong câu lệnh, nội dung câu lệnh rồi đưa ra các phản hồi với nội dung và cảm xúc phù hợp. Chính vì vậy nghiên cứu về cảm xúc trong tiếng nói trở nên rất quan trọng trong lĩnh vực tương tác người máy. Hiện nay, các nghiên cứu về tiếng nói tiếng Việt với giọng trần thuật (bình thường) đã có nhiều kết quả rất tốt. Trong khi đó các nghiên cứu về phương diện cảm xúc trong tổng hợp hay nhận dạng tiếng Việt chưa nhiều. Một số nghiên cứu về cảm xúc tiếng Việt đã được công bố thường được thực hiện trên ngữ liệu đa thể thức, kết hợp video biểu hiện khuôn mặt, cử chỉ và tiếng nói với ứng dụng chủ yếu để tổng hợp tiếng Việt. Chẳng hạn nghiên cứu trong [23], [24] đã thử nghiệm mô hình hóa ngôn điệu tiếng Việt với ngữ liệu đa thể thức nhằm tổng hợp tiếng Việt biểu cảm. Các tác giả của [20] đã đề xuất mô hình biến đổi tiếng Việt nói để tạo biểu cảm trong kênh tiếng nói cho nhân vật ảo nói tiếng Việt. Trong nghiên cứu này, ngữ liệu có cảm xúc bao gồm các phát âm tiếng Việt của một nghệ sĩ nam và một nghệ sĩ nữ phát âm 19 câu ở năm trạng thái cơ bản: tự nhiên, vui, buồn, hơi giận, rất giận. Đối với nhận dạng cảm xúc tiếng Việt, nghiên cứu [21] đã sử dụng SVM (Support Vector Machines) để phân lớp với đầu vào là tín hiệu điện não (EEG). Kết quả cho thấy có thể nhận dạng được trên thời gian thực 5 trạng Các công trình nghiên cứu, phát triển và ứng dụng CNTT-TT Tập V-1, Số 15 (35), tháng 6/2016 -87- thái cảm xúc cơ bản với độ chính xác trung bình là 70,5%. Một số tác giả Trung Quốc [28], [29] có kết hợp với sinh viên Việt Nam xây dựng ngữ liệu cảm xúc tiếng Việt theo cách đóng kịch biểu lộ cảm xúc. Người nói là các sinh viên Việt Nam, trong nghiên cứu [28] có 2 nam, 2 nữ, còn trong [29] có 6 người nói với 6 cảm xúc vui, bình thường, buồn, ngạc nhiên, tức giận, sợ hãi. Các tác giả ban đầu đã xây dựng ngữ liệu với ý định nghiên cứu chéo ngôn ngữ Việt Nam và Trung Quốc. Các tham số của ngữ liệu được phân tích phục vụ nhận dạng cảm xúc bao gồm cao độ (pitch), các formant F1, F2, F3 và năng lượng tín hiệu. GMM (Gaussian Mixture Model) đã được sủ dụng trong [28] còn MRF (Markov Random Fields) được sử dụng trong [29] để nhận dạng cảm xúc. Những tham số cơ bản nhất để phân biệt các cảm xúc bao gồm tần số cơ bản F0, năng lượng tiếng nói [7]. Sự phân biệt này có thể được xác minh thông qua cách sử dụng các phương pháp phân tích và kiểm định giả thuyết thống kê. Bài báo này sẽ trình bày về kết quả nghiên cứu sử dụng phương pháp phân tích ANOVA và kiểm định T để giới thiệu phần thử nghiệm phân lớp cảm xúc. Nội dung tiếp theo của bài báo gồm các phần sau: Phần II trình bày về các tham số cơ bản đặc trưng cho cảm xúc trong tiếng nói; Phần III mô tả phương pháp xây dựng ngữ liệu tiếng Việt có cảm xúc; Phần IV sử dụng phương pháp phân tích phương sai ANOVA và kiểm định T để đưa ra kết quả phân tích thống kê sự khác biệt của các cảm xúc theo tần số cơ bản F0 và năng lượng tiếng nói; Phần V trình bày kết quả thử nghiệm nhận dạng cảm xúc tiếng Việt; Phần VI tổng kết và định hướng nghiên cứu tiếp theo. II. CÁC THAM SỐ VỀ CẢM XÚC TRONG TIẾNG NÓI Trong giao tiếp thông thường giữa người với người, ngoài nội dung của thông điệp trao đổi thì người nghe cũng thu được rất nhiều thông tin thông qua các cảm xúc của người nói lúc đó. Vì vậy, trong giao tiếp người máy cần phát triển các hệ thống tiếng nói có thể xử lý các cảm xúc kèm theo nội dung cần truyền tải. Các mục tiêu cơ bản của hệ thống xử lý tiếng nói có cảm xúc là nhận dạng cảm xúc thể hiện trong tiếng nói và tổng hợp cảm xúc mong muốn trong tiếng nói để truyền tải ý định nội dung. Từ góc độ kỹ thuật, để làm được điều này, cần phải tìm được cá ... IỆT Với bộ ngữ liệu cảm xúc tiếng Việt BKEmo, các bộ phân lớp SMO, lBk, trees J48 đã được thử nghiệm để nhận dạng cảm xúc. Các bộ phân lớp này thuộc công cụ Weka gồm tập hợp các thuật giải học máy dùng cho khai phá dữ liệu do Đại học Waikato, NewZealand phát triển [34]. SMO (Sequential Minimal Optimization) [32] là thuật giải tối ưu hóa cực tiểu lần lượt để huấn luyện bộ phân lớp hỗ trợ véc- tơ dùng kernel đa thức hoặc Gauss. lBk là bộ phân lớp k láng giềng gần nhất sử dụng độ đo khoảng cách Ơclit [34]. Bộ phân lớp trees J48 [33] được dùng để có các luật từ các cây quyết định riêng phần đã được xây dựng bằng cách sử dụng J48. J48 là cài đặt mã nguồn mở Java của thuật giải C4.5 và thuật giải này được dùng để tạo cây quyết định do Ross Quinlan phát triển Ngữ liệu dùng cho thử nghiệm gồm 5584 file tương ứng với 4 cảm xúc được 16 nghệ sĩ (8 giọng nam và 8 giọng nữ) thể hiện. Số file này được chia làm 2 phần bằng nhau, một phần dùng để huấn luyện và phần còn lại dùng cho nhận dạng. Thử nghiệm nhận dạng được thực hiện theo phương pháp đánh giá chéo (cross- validation). Bộ tham số đặc trưng được trích rút nhờ công cụ OpenSMILE [35] với 384 tham số bao gồm: năng lượng, MFCC, tỉ lệ biến thiên qua trục không, tần số cơ bản F0, xác suất xuất hiện âm hữu thanh. Các tham số này lại được đánh giá theo giá trị cực đại, cực tiểu, vị trí xuất hiện cực đại, vị trí xuất hiện cực tiểu, dải giá trị, giá trị trung bình, độ lệch chuẩn, độ lệch phổ so với tần số trung bình (Skewness), độ khác biệt phổ quanh tâm phổ so với phân bố Gauss (Kurtosis). Bảng 7. Ma trận nhầm lẫn nhận dạng cảm xúc với 384 tham số Bộ phân lớp Tức Vui BT Buồn SMO Tức 1341 51 4 0 Vui 41 1342 13 0 BT 4 8 1300 84 Buồn 3 11 75 1307 lBk Tức 1383 9 2 2 Vui 13 1380 1 2 BT 0 0 1367 29 Buồn 0 1 43 1352 Trees J48 Tức 1084 225 62 25 Vui 216 1103 54 23 BT 61 58 1128 149 Buồn 19 25 164 1188 Bảng 7 là ma trận nhầm lẫn nhận dạng cảm xúc dùng bộ 384 tham số còn Bảng 8 là ma trận nhầm lẫn nhận dạng cảm xúc chỉ dùng các tham số liên quan đến F0 và năng lượng. Kết quả trên cả hai bảng đều dùng các bộ phân lớp SMO, lBk, trees J48. Bảng 7 cho thấy tỉ lệ nhận dạng đúng trung bình cao nhất cho cả 4 Các công trình nghiên cứu, phát triển và ứng dụng CNTT-TT Tập V-1, Số 15 (35), tháng 6/2016 -96- cảm xúc đạt 98,17% với bộ phân lớp lBk còn tỉ lệ nhận dạng đúng trung bình thấp nhất là 80,64% với bộ phân lớp trees J48. Đối với Bảng 8, khi số tham số giảm xuống chỉ còn 48 tham số liên quan đến F0 và năng lượng, tỉ lệ nhận dạng đúng đều giảm so với Bảng 7 tuy nhiên vẫn giữ quy luật tỉ lệ nhận dạng đúng cao nhất cho bộ phân lớp lBk và thấp nhất cho bộ phân lớp trees J48. Trường hợp chỉ sử dụng các tham số liên quan đến F0 và năng lượng, tỉ lệ nhận dạng đúng trung bình cao nhất giảm xuống còn 82,59% và tỉ lệ nhận dạng đúng trung bình thấp nhất giảm xuống còn 75,25%. Nhìn chung, các kết quả này đều khả quan so với một số kết quả nhận dạng cảm xúc tiếng Việt đã được công bố [28], [29] hoặc kết quả nhận dạng cảm xúc của một số ngôn ngữ khác [36-39]. Bảng 8. Ma trận nhầm lẫn nhận dạng cảm xúc với 48 tham số liên quan đến F0 và năng lượng Bộ phân lớp Tức Vui BT Buồn SMO Tức 1144 178 53 21 Vui 182 1103 100 11 BT 31 99 903 363 Buồn 14 33 156 1193 lBk Tức 1186 144 45 21 Vui 139 1174 63 20 BT 30 50 1093 223 Buồn 21 13 203 1159 trees J48 Tức 1084 218 70 24 Vui 227 1052 99 18 BT 77 92 969 258 Buồn 17 33 249 1097 VI. KẾT LUẬN VÀ HƢỚNG PHÁT TRIỂN Trong bài báo này, các tham số cơ bản của các cảm xúc, việc xây dựng ngữ liệu cảm xúc cho tiếng Việt, sử dụng phân tích phương sai ANOVA và kiểm định T để đánh giá sự biến thiên F0 và năng lượng trung bình giữa các cảm xúc đã được trình bày. Kết quả phân tích cho thấy tần số cơ bản F0 là một tham số đáng tin cậy để phân biệt giữa các cảm xúc. Năng lượng cũng là một tham số hiệu quả về phân biệt cảm xúc, phản ánh rõ nét trên nam giới hơn so với trên nữ giới. Trong số các bộ phân lớp được sử dụng để thử nghiệm bước đầu nhận dạng cảm xúc theo bộ ngữ liệu BKEmo, bộ phân lớp lBK cho kết quả nhận dạng tốt nhất. Hướng nghiên cứu tiếp theo của chúng tôi là tập trung vào phân tích ảnh hưởng đến cảm xúc của các tham số như trường độ, tốc độ nói cũng như một số tham số khác liên quan đến nguồn âm và tiến hành nhận dạng cảm xúc tiếng Việt dùng các mô hình nhận dạng khác nhau sử dụng ngữ liệu đã được xây dựng. Bên cạnh đó sẽ mở rộng nghiên cứu cho các hình thái cảm xúc đa dạng hơn. LỜI CẢM ƠN Bài báo này được thực hiện trong khuôn khổ đề tài nghiên cứu “Xây dựng bộ ngữ liệu cảm xúc tiếng Việt” của Trường Đại học Bách khoa Hà Nội. Các tác giả chân thành cảm ơn Trường Đại học Bách khoa Hà Nội, Phòng Khoa học Công nghệ, Viện Công nghệ Thông tin và Truyền thông đã hỗ trợ để chúng tôi có thể thực hiện thành công đề tài. TÀI LIỆU THAM KHẢO [1] RODDY COWIE, MARC SCHRÖDER, “Piecing together the emotion jigsaw”, Workshop on Machine Learning for Multimodal Interaction (MLMI04), Martigny, Switzerland, June 21-23, 2004. [2] MARIA SCHUBIGER, “English intonation: its form and function”. Language Vol. 36, No. 4, 1960, pp. 544-548. [3] KLAUS. R. SCHERER, “Vocal communication of emotion: A review of research paradigms”, Speech Communication, vol. 40, 2003, pp. 227–256. [4] JANET CAHN, “The generation of affect in synthesized speech”. Journal of American Voice Input/Output Society, vol. 8, 1990, pp. 1–19. [5] CARL E. WILLIAMS, KENNETH N. STEVENS, “Emotions and speech: Some acoustical correlates”. The Journal of the Acoustical Society of America Vol. 52 (4), 1972, pp. 1238-1250. [6] FELIX BURKHARDT, WALTER F. SENDLMEIER, “Verification of acoustical correlates of emotional speech using formant-synthesis”. In Proceedings of the ISCA Workshop on Speech and Emotion, Newcastle, Northern Ireland, UK, 2000. [7] SYLVIE MOZZICONACCI, DIK J. HERMES, “Role of intonation patterns in conveying emotion in speech”. In Proceedings of ICPhS 1999 , San Francisco 1999, pp. 2001-2004. [8] JANET E. CAHN, “Generating expression in synthesized speech”, Master's Thesis, Massachusetts Institute of Technology, May 1989. Các công trình nghiên cứu, phát triển và ứng dụng CNTT-TT Tập V-1, Số 15 (35), tháng 6/2016 -97- [9] JEAN VROOMEN, RENÉ COLLIER, SYLVIE MOZZICONACCI, "Duration and intonation in emotional speech”, Proceedings of the Third European Conference on Speech Communication and Technology, Berlin, Germany, September 21-23, 1993. [10] DEEPA P. GOPINATH, SHEEBA P.S, ACHUTHSANKAR S. NAIR, “Emotional Analysis for Malayalam Text to Speech Synthesis Systems”, Proceedings of the Setit 2007 - 4th International Conference: Sciences of Electronic, Technologies of Information and Telecommunications, Tunisia, March 25- 29, 2007. [11] TSANG-LONG PAO, YU-TE CHEN, JUN-HENG YEH, WEN_YUAN LIAO, “Combining acoustic features for improved emotion recognition in mandarin speech”, in ACII (Affective Computing and Intelligent Interaction), Beijing, China, October 22-24, 2005. [12] FRANK DELLERT, THOMAS POLZIN, ALEX WAIBEL, “Recognising emotions in speech”, ICSLP 96, Philadelphia, USA, Oct 03-06, 1996. [13] IAIN R. MURRAY, JOHN L. ARNOTT, ELIZABETH A. ROHWER, “Emotional stress in synthetic speech: Progress and future directions”, Speech Communication, vol. 20, Nov 1996, pp. 85-91. [14] SINÉAD MCGILLOWAY, RODDY COWIE, ELLEN DOUGLAS-COWIE, STAN GIELEN, MACHIEL WESTERDIJK, SYBERT STROEVE “Approaching automatic recognition of emotion from voice: A rough benchmark”, Proceedings of the ISCA Workshop on Speech and Emotion, Newcastle, Northern Ireland, UK, Sep 5-9, 2000. [15] JAY L. DEVORE, “Probability and Statistics for Engineering and the Sciences”, Eighth Edition, Brooks/Cole Edition, 2010. [16] YIXIONG PAN, PEIPEI SHEN, LIPING SHEN, “Speech Emotion Recognition Using Support Vector Machine”, International Journal of Smart Home Vol. 6, No. 2, April, 2012, pp 101-108. [17] R. SUBHASHREE1, G. N. RATHNA, “Speech Emotion Recognition: Performance Analysis based on Fused Algorithms and GMM Modelling”, Indian Journal of Science and Technology, Vol 9(11), March 2016, pp. 1-8. [18] H. MIWA, T. UMETSU, A. TAKANISHI, H. TAKANOBU, “Robot personalization based on the mental dynamics”, IEEE/RSJ Conference on Intelligent Robots and Systems, vol 1, Takamatsu, Oct 31-Nov 5, 2000. [19] KUN HAN, DONG YU, IVAN TASHEV, “Speech Emotion Recognition Using Deep Neural Network and Extreme Learning Machine”, INTERSPEECH 2014, Singapore, September 14-18, 2014 [20] THI DUYEN NGO, THE DUY BUI, “A study on prosody of Vietnamese emotional speech”, Proceedings of the Fourth International Conference on Knowledge and Systems Engineering (KSE 2012), IEEE, Danang city, Vietnam, Aug 17-19, 2012 [21] VIET HOANG ANH, MANH NGO VAN, BANG BAN HA, THANG HUYNH QUYET, “A real-time model based Support Vector Machine for emotion recognition through EEG”, International Conference on Control, Automation and Information Sciences (ICCAIS), Ho Chi Minh city, Vietnam, Nov 26-29, 2012. [22] JOHANNES PITTERMANN, ANGELA PITTERMANN, WOLFGANG MINKER, “Handling Emotions in Human-Computer Dialogues”, Springer, 2010. [23] DANG-KHOA_MAC, ERIC CASTELLI, VÉRONIQUE AUBERGÉ, “Modeling the Prosody of Vietnamese Attitudes for Expressive Speech Synthesis”, Workshop of Spoken Languages Technologies for Under-resourced Languages (SLTU 2012), Cape Town, South Africa, May 7-9, 2012. [24] DANG-KHOA MAC, DO-DAT TRAN, “Modeling Vietnamese Speech Prosody: A Step-by-Step Approach Towards an Expressive Speech Synthesis System”, Springer, Trends and Applications in Knowledge Discovery and Data Mining, vol 9441, Springer, 2015, pp. 273-287. [25] RAHUL B. LANEWAR, SWARUP MATHURKAR, NILESH PATEL, “Implementation and Comparison of Speech Emotion Recognition System using Gaussian Mixture Model (GMM) and K-Nearest Neighbor (K-NN) techniques”, Procedia Computer Science, vol 49, Elsevier, 2015, pp. 50-57. [26] MOATAZ EL AYADI, MOHAMED S. KAMEL, FAKHRI KARRAY, “Survey on speech emotion recognition: Features, classification schemes, and databases”, Pattern Recognition Journal, vol 44, Issue 3, Elsevier, March 2011, pp 572–587. [27] www.praat.org, last visited 20/02/2016. [28] LA VUTUAN, HUANG CHENG-WEI, HA CHENG, ZHAO LI, “Emotional Feature Analysis and Recognition from Vietnamese Speech”, Journal of Signal Processing, China, 2013. [29] JIANG ZHIPENG, HUANG CHENGWEI, “High- Order Markov Random Fields and Their Applications in Cross-Language Speech Recognition”, Cybernetics and Information Technologies, Volume 15, No 4, Sofia, 2015, pp 50-57. [30] ROBERT PLUTCHIK, HENRY KELLERMAN, “Emotion: Theory, research and experience”, vol 4. Academic Press, New York, USA, 1989. [31] NGUYỄN TÔN NHAN, PHÚ VĂN HẲN, “Từ điển tiếng Việt”, Nhà xuất bản Từ điển Bách Khoa, 2013. Các công trình nghiên cứu, phát triển và ứng dụng CNTT-TT Tập V-1, Số 15 (35), tháng 6/2016 -98- [32] JOHN C. PLATT, “Technical Report MSR-TR-98-14”, Microsoft Research, April 21, 1998 [33] QUINLAN, J. R. “C4.5: Programs for Machine Learning”, Morgan Kaufmann Publishers, 1993. [34] WITTEN, IAN H., AND EIBE FRANK, “Data Mining: Practical machine learning tools and techniques”, Morgan Kaufmann Publishers, 2005. [35] EYBEN, FLORIAN, MARTIN WÖLLMER, AND BJÖRN SCHULLER, "Opensmile: the munich versatile and fast open-source audio feature extractor", Proceedings of the 18th ACM international conference on Multimedia, Firenze, Italia, Oct 25-29, 2010. [36] SIQING WUA, TIAGO H. FALKB, WAI-YIP CHAN, “Automatic speech emotion recognition using modulation spectral features”, Speech Communication, Volume 53, Issue 5, 2011, pp. 768–785. [37] S. LALITHA, ABHISHEK MADHAVAN, BHARATH BHUSHAN, SRINIVAS SAKETH, “Speech emotion recognition”, Proceedings of the International Conference on Advances in Electronics, Computers and Communications, Bangalore, India, Oct 10-11, 2014. [38] MARTIN GJORESKI, HRISTIJAN GJORESKI, ANDREA KULAKOV, “Machine Learning Approach for Emotion Recognition in Speech”, Informatica, vol 38, no 4, 2014, pp. 377-384. [39] ANKUSH CHAUDHARY,ASHISH KUMAR SHARMA, JYOTI DALAL, LEENA CHOUKIKER, “Speech Emotion Recognition”, Journal of Emerging Technologies and Innovative Research, vol. 2, issue 4, 2015, pp 1169-1171. Nhận bài ngày: 26/02/2016 SƠ LƢỢC VỀ TÁC GIẢ LÊ XUÂN THÀNH Sinh năm 1982. Tốt nghiệp ĐH Bách khoa Hà Nội năm 2006. Hiện tại là giảng viên và nghiên cứu sinh tại Bộ môn Kỹ thuật Máy tính, Trường ĐH Bách khoa Hà Nội. Lĩnh vực nghiên cứu: Xử lý tín hiệu, Xử lý tiếng nói, Hệ nhúng. Email: thanhlx@soict.hust.edu.vn Điện thoại : 0906755789 ĐÀO THỊ LỆ THỦY Sinh năm 1976. Tốt nghiệp Học viện Kỹ thuật Quân sự năm 2008. Hiện đang là nghiên cứu sinh tại Viện CNTT và Truyền thông, Trường ĐH Bách khoa Hà Nội. Lĩnh vực nghiên cứu: Xử lý tín hiệu, Xử lý tiếng nói, công nghệ phần mềm. Email: thuydt@hht.edu.vn TRỊNH VĂN LOAN Sinh năm 1956. Tốt nghiệp ĐH Bách khoa Hà Nội năm 1978. Nhận bằng DEA năm 1988 và nhận bằng Docteur năm 1992 tại Viện ĐH Bách khoa Quốc gia Grenoble (INPG) Pháp. Hiện công tác tại Viện CNTT và Truyền thông, Trường ĐH Bách khoa Hà Nội. Lĩnh vực nghiên cứu: Xử lý tín hiệu, Xử lý tiếng nói, Hệ nhúng. Email: loantv@soict.hust.edu.vn NGUYỄN HỒNG QUANG Sinh năm 1978. Tốt nghiệp ĐH Bách khoa Hà Nội năm 2000. Nhận bằng tiến sỹ tại Trường ĐH Avignon, CH Pháp năm 2008. Hiện tại là giảng viên Viện CNTT và Truyền thông, Trường ĐH Bách khoa Hà Nội. Lĩnh vực nghiên cứu: Xử lý tiếng nói, Học máy thống kê. Email: quangnh@soict.hust.edu.vn

File đính kèm:

cam_xuc_trong_tieng_noi_va_phan_tich_thong_ke_ngu_lieu_cam_x.pdf

cam_xuc_trong_tieng_noi_va_phan_tich_thong_ke_ngu_lieu_cam_x.pdf